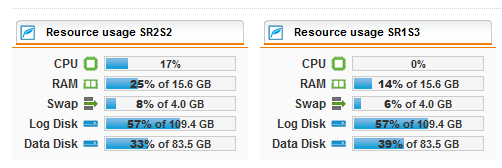

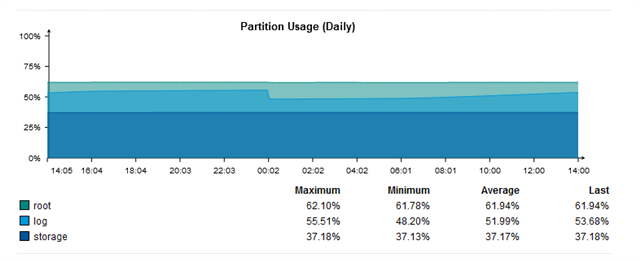

Wir erhalten Meldungen, dass auf einer SG450, HA Node2 (Slave), die Logpartion einen Schwellwert (>65%) erreicht. Auf dem Master liegt die Auslastung laut daily report mit dem Maximum <60% . Was läuft hier falsch bzw. kann ich prüfen?

This thread was automatically locked due to age.