Hallo zusammen,

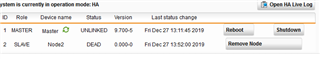

leider funktioniert nach einem damalgen Neustart vor 2 Wochen unser HA an der Sophos nicht mehr.

Beide Geräte Geräte sind auf dem Stand 9.700-5 und ich habe beide Geräte mehrmals resettet ( factory reset am Gerät) und habe auch mehrmals HA neu eingerichtet.

Des Weiteren habe ich die Notes getauscht, habe ein Backup eingespuielt und habe den damaligen Master versucht in das HA reinzubekommen.

Leider geht dieser kurz darauf auf den Status erst syncing und dann auf "Dead".

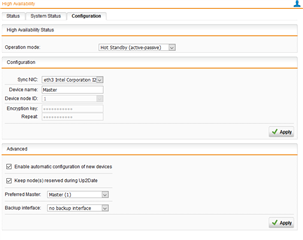

Hier meine Konfig und das Log:

This thread was automatically locked due to age.